|

قوقل يطلب منى ملفين للمنتدى..كيف نحصل عليهم

السلام عليكم

قوقل يطلب منى ملفين للمنتدى..كيف نحصل عليهم sitmap.xml robot.txt هل هم برمجه ام هناك برامج اومواقع تعمل هالشىء ؟ مع الشكر مقدما |

بخصوص ملف robots.txt

يمكن مراجعة هدا موضوع http://www.arabwebtalk.com/showthread.php?t=39803 كدلك http://qatardr.net/class/905 افتح المفكرة و أكتب الموجود الان في المثال وضعه على الدليل الرئيسي لموقعك لاحظ اني منعت كثير من المواقع من دخول موقعي وهده مواقع مهمتها سرقة الايملات و عمل spam كدلك منعت قوقل و بقية محركات البحث من دخول عدد من المجلدات المحظورة مثل مجلد admin و admincp و غيرها http://www.zhra.net/sitemap.xml كود:

# Allow Everything Disallow: يوجد برامج تقوم بعمل ذلك و استطيع اقول ان اغلب هده البرامج لا تنجح في عمل sitemap مميزة لموقعك ولو كان موقعك صغير فالافضل ان تعملها بطريقة يدوية يمكن هذا الموقع يعمل لك sitemap الى 500 رابط من موقعك سوف ابحث لك عن درس مبسط قليلاً وسوف تتعلم ذلك |

Sitemap.xml

كود:

<?xml version="1.0" encoding="UTF-8"?>الشرح 1- استخدم برنامج المفكرة ولا تستخدم اي برنامج اخر لعمل sitemap لا تستخدم اي محرر للغة html مثل فرنت بيج // فقط المفكرة هذا الشرح من قوقل https://www.google.com/webmasters/to...r otocol.html يوجد دوال ليس لها حاجة متل اهمية الرابط و الفترة الزمنية لزيارة الرابط و غيرها لان محرك البحث سوف يعمل حسب ماهو ستاندر لديه لذلك انا تجاهلت ادراج تلك الدوال 2- في المثال السابق يوجد 4 اسطر السطر 1+2 هذه لا تتكر السطر 4 لإغلاق الدالة 3- بقي عندنا السطر رقم (3) وهو المهم تعمل له نسخ و لصق وفي كل مرة تضع رابط جديد من روابط موقعك نفرض ان عندك منتدى به عدد 2000 من الاعضاء و كذلك عدد 2000 من المواضيع + عدد 2000 من المواضيع المؤرشفة ادا تكرر هدا السطر 6000 مرة ملاحظات يجب ان تعرف مكان الملف sitemap.xml في ملف robots.txt يجب ان لا يزيد حجمملف sitemap عن 5 ميجا و انا بفضل انه ما بيزيد عن 2 ميجا اذا عملت عدد 2 ملف sitemap واحد للموقع و الاخر للمنتدى هنا ملف sitemap.xml الخاص بالمنتدى يجب يكون في الدليل الرئيسي للمنتدى مثال: www.your domain.com/vb/sitemap.xml وان تعرف مكانه في قوقل لخدمات مدراء المواقع و كذلك في ملف robots.txt وكتير اشياء لكن يهمني ان توصل الفكرة لديك |

الله يعطيك العافيه اخوى اواختى زهره

حقيقة الكلام جميل لكن صدع راسى وانا جالسه اقراه الحين بخصوص robots.txt انسخ الكود فى الاعلى وافتح مفكره واضعه فى الملف الرئيسى ؟ طيب انا عندى دليل مواقع فى الصفحه الرئيسيه وعندى منتدى فى صفحه اخرى vb ما العمل ؟ اما بالنسبة لـ sitemap.xml صعب على فهمه بصراحه مع الشكر |

المجلدات التي لا تريد ان يدخلها محركات البحث اضيفيا

هذا ملف روبوت جاهز من موقعي أنسخة في ملف تكست وضعه على الدليل الرئيسي http://www.zhra.net/robots.txt تحت هذا السطر ضعي المجلدات التي رلا تريدين ان يدخلها محركات البحث CSS test pages unsafe for IE4.01 Mac, don't go there مثل admincp images includes وغيرها وهذه قائمة بالربوتات السيئة التي تستهلك قدر كبير من الباندودث و مخصصة للسبام http://www.yellowpipe.com/yis/tools/...afe-robots.php أما sitemap يمكن من ذلك الموقع عمل سايت صغيرة 500 رابط فقط |

يسلمو والله ما قصرتى

راح انسخ الملف لكن بس اغير من رابط موقعك الى رابط موقعى صح ؟ ثانى شى انا ما عندى سايت مابز sitmap.xml عادى صح اضع الروبوت ؟ |

بروكت توليد خريطة المنتدى لجوجل وياهو الإصدار الثاني والاخير

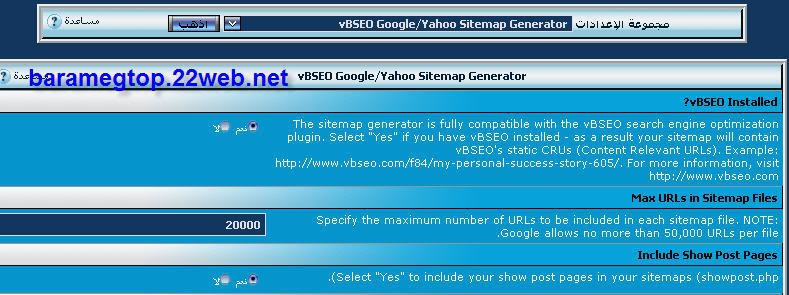

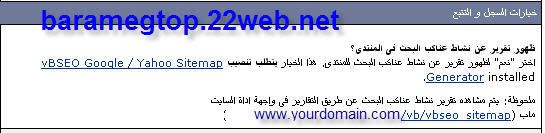

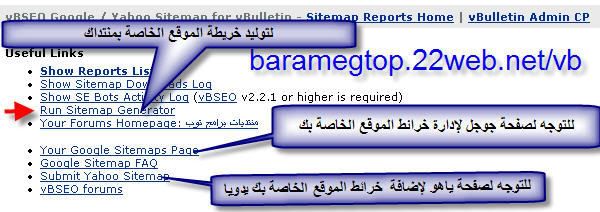

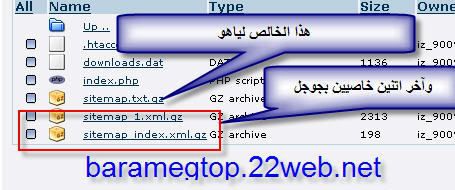

أصلي بلا أي تلاعب وهاهو رابط الشركة المنتجة للتأكد من الإصدار http://www.vbulletin.org/forum/showt...php?t=10 0435  يقوم البرودت بتوليد خريطة المنتدى المتوافقة مع محرك البحث جوجل و ياهو ويقوم البرودكت بإخبار جوجل تلقائيا بخريطة المنتدى الجديدة بمجرد إنشائها لكن بالنسبة لياهو عليك اخبارها بنفسك على الأقل لأول مرة وده رابط الياهو لرفع السايت ماب الخاصة بموقعك [/color][/size]http://submit.search.yahoo.com/free/request ولاحظ هنا أن البرودكت العملاق vbseo يطلبه لتوليد السايت ماب للمنتدى  طريقة الإستخدام يمكنك الذهاب الى www.yourdomain.com/vb/vbseo_sitmap  بعد توليد السايت ماب الخاصة بمنتداك إذهب إلى www.yourdomain.com/vb/vbseo_sitmap/data ستجد ملفات السايت ماب  الآن تذهب لياهو وتعطيه رابط هذا السايت ماب مثال لياهو www.yourdomain.com/vb/vbseo_sitmap/data/sitemap.tx t.gz الامتداد .gz هوضغط للسايت ماب لا تغيره لأن ياهو يتعرف عليه بشكل طبيعي طريقة التركيب كل ما عليك هو رفع المجلد vbseo_sitemap الى مجلد VB لديك وإستدعاء البرودكت من لوحة تحكم الإدارة للتحميل كلمة السر لفك الضغط baramegtop.22web.net |

| جميع الأوقات بتوقيت مكة المكرمة. الساعة الآن » 02:03 AM. |

Powered by vBulletin

Copyright ©2000 - 2024, Jelsoft Enterprises Ltd.

Copyright © ArabWebTalk.Com 2004-2012